Le BRGM accorde une place de plus en plus importante aux approches d’intelligence artificielle et de jumeau numérique, qui transforment les pratiques géoscientifiques. © BRGM

Numérique pour les géosciences

Résultat remarquable / La montée en puissance de l’IA dans les géosciences

« Nous utilisons l’intelligence artificielle depuis longtemps, par exemple dans le traitement du signal pour l’évaluation de l’aléa sismique, rappelle Nicolas Gilardi. Ce qui a changé, c’est que nous avons accès aujourd’hui à de nouveaux algorithmes aux performances exceptionnelles ! » Et cela élargit considérablement le champ des possibles… Le BRGM s’appuie par exemple sur les avancées de l’IA en traitement de l’image pour le projet régional CERES, qui vise à cartographier et caractériser, à partir de vues satellitaires, des éléments exposés du Centre-Val de Loire. L’intelligence artificielle facilite également le traitement du langage naturel, comme l’illustre le projet RéSoCIO (ANR) qui cherche à automatiser l’exploitation des données textuelles du réseau social X (ex-Twitter) lors d’une catastrophe naturelle à cinétique rapide, comme les crues éclair et les séismes. L’objectif est d’apporter au plus vite des informations pertinentes et consolidées aux services chargés de gérer la crise.

Cet exemple met en évidence les premiers bénéfices de l’intelligence artificielle : le gain de temps et sa capacité à traiter de gros volumes de données. « Cet outil peut aider les chercheurs dans leur veille sur les nouvelles connaissances produites, ainsi que pour la complétion des bases de données qui servent de support à leurs travaux », indique Cécile Gracianne. L’IA contribue alors à enrichir la connaissance. Grâce également à l’automatisation d’opérations réalisées jusque-là manuellement, comme le pré-traitement des données géophysiques collectées par levés aéroportés ou de terrain, les experts peuvent se concentrer sur les tâches à forte valeur ajoutée. L’intelligence artificielle rend même certaines opérations envisageables, comme la compilation des données sur les forages que recèle la Banque du sous-sol (BSS) : « L’IA pourrait extraire les informations les plus utiles des centaines de milliers de fiches de la BSS, en traitant peut-être jusqu’à 80 % de ces documents, avec une rapidité d’autant plus grande que nous pourrions lancer simultanément plusieurs requêtes », espère Nicolas Gilardi.

Dépasser les limites

Les chercheurs s’appuient ainsi de plus en plus sur l’IA pour dépasser les limites auxquelles ils se heurtent : le temps de traitement donc, mais aussi la complexité des phénomènes en jeu. C’est le cas par exemple dans le projet régional Junon, qui consiste à créer un jumeau numérique de la plaine de Beauce afin notamment de prévoir l’état futur de la nappe souterraine. Ici, l’intelligence artificielle est utilisée pour prédire des séries temporelles, c’est-à-dire pour estimer l’évolution de variables au cours du temps, en l’occurrence les niveaux piézométriques de la nappe sur une période donnée. Or ces niveaux sont régis par des processus complexes difficiles à modéliser classiquement : la pluie, l’ensoleillement, la géologie, les plantes, etc. L’IA permet de construire automatiquement et rapidement des liens entre les variations des différentes données observées.

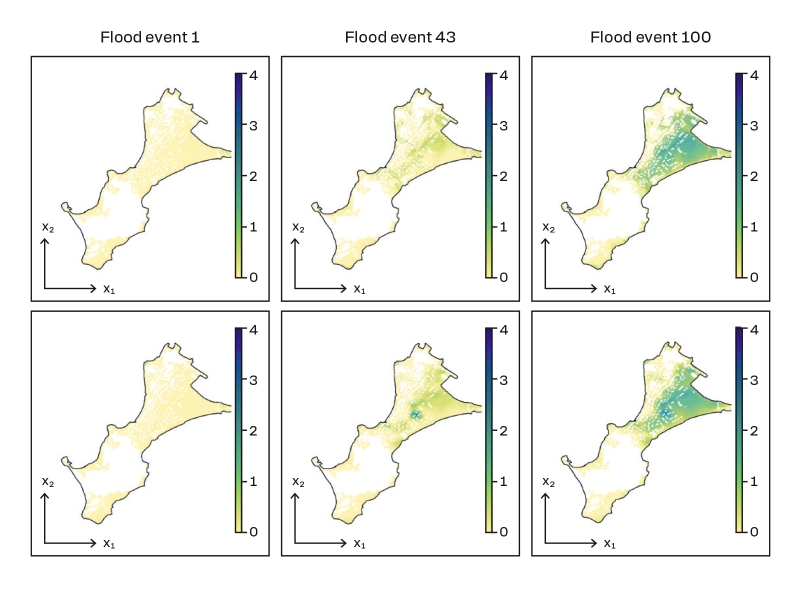

Comment ? « Le modèle IA de machine learning recourt à la statistique pour établir des corrélations, tandis que le modèle numérique résout les équations physiques décrivant le phénomène : ce sont deux approches différentes, qui peuvent se nourrir mutuellement », explique Jérémy Rohmer. Lequel cite l’exemple des projets SIRENES dans les Hauts-de-France et ORACLES en Nouvelle-Aquitaine, sur l’anticipation et la gestion du risque de submersion marine. Dans ce dernier, l’IA se fonde sur des données issues de simulations numériques pour produire beaucoup plus vite qu’un modèle numérique des cartes d’inondation dans le bassin d’Arcachon.

Comparaison des cartes prédictives d’inondation simulées numériquement (haut), pour trois événements, avec les résultats issus de modèles de machine learning (bas), sur le site de Gavres en Bretagne (projet ANR RISCOPE). © BRGM

Comprendre l’IA

L’IA facilite enfin l’interpolation spatiale entre des données, pour fournir des informations sur toute une surface. Là encore de façon très rapide… mais pas sans incertitude. C’est sur cette question que porte le projet HOUSES (ANR), à partir de l’étude de différents cas : la cartographie de la concentration d’hydrocarbures dans le sol de la ville de Toulouse, la contamination des eaux souterraines par des éléments traces dans le Bassin parisien, l’érosion des dunes en milieu côtier et le suivi de données géophysiques. « Nous effectuons une analyse critique de la chaîne de traitement des données, incluant l’interpolation effectuée par l’IA, afin d’évaluer l’incertitude des prévisions et de leur attribuer une note de confiance », avance Jérémy Rohmer.

Comme AIDA (ANR) qui vise à développer le concept d’« explicabilité actionnable » des modèles d’apprentissage, de plus en plus de projets cherchent à comprendre comment l’intelligence artificielle établit ses corrélations. Un sujet d’autant plus sensible que le BRGM est amené, dans ses missions d’appui aux politiques publiques, à formuler des recommandations qui peuvent avoir un impact sociétal. « Il est essentiel de savoir comment l’IA est parvenue à ses prévisions pour renforcer la validité de nos résultats et l’acceptabilité des solutions proposées », souligne Michaël Chelle. « La nature des données géoscientifiques – hétérogènes, issues de modèles différents, souvent limitées dans l’espace et/ou dans le temps, et à la valeur incertaine car portant sur le sous-sol, par essence inaccessible – entrave la performance de l’IA », reconnaît Cécile Gracianne. Pour autant, « cette technologie complémentaire fait déjà évoluer notre approche et nos pratiques scientifiques », observe Michaël Chelle.

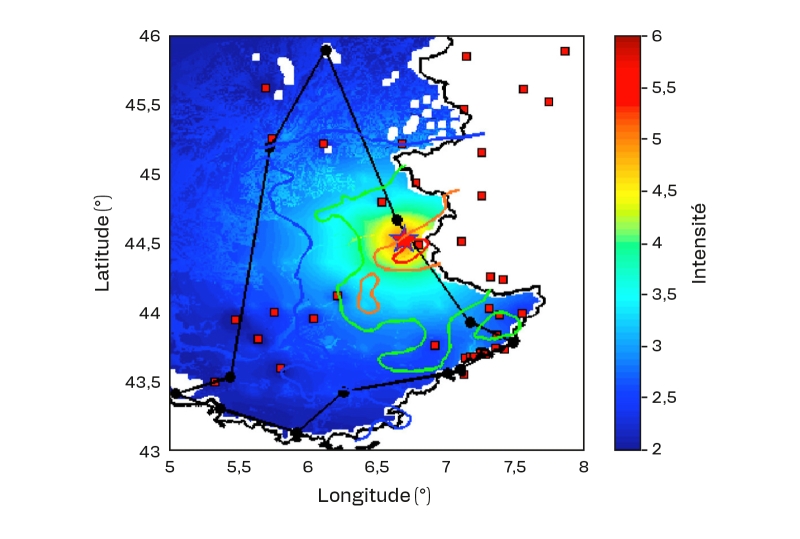

L’apport complémentaire des données issues des réseaux sociaux et des mesures instrumentales permet de produire une cartographie plus précise du séisme : délimitée en noir, la zone où il a été ressenti, d’après les témoignages recueillis sur Twitter ; en rouge, orange, vert et bleu, les zones d’intensité sismique établies par un modèle physique de propagation. © BRGM